首发:AI公园公众号

作者:Synced

编译:ronghuaiyang

导读

不仅对CNN的backbone预训练,Transformer也要预训练,而且还是无监督的。

论文地址:https://arxiv.org/pdf/2011.09...

华南理工大学和腾讯微信人工智能研究人员的一项新研究是利用Transformer架构进行目标检测的最新成果。该团队提出了一个他们称为random query patch detection的任务,用无监督的方式预训练DETR(检测变压器)的目标检测。无监督预训练的DETR (UP-DETR)显著提高了DETR的性能,在流行的目标检测数据集PASCAL VOC和COCO上具有更快的收敛速度和更高的精度。

今年5月,Facebook AI Research推出了DETR框架,通过Transformer编码器-解码器架构,将物体检测视为直接预测问题。它已经达到了与SOTA方法(如Faster R-CNN基线)竞争的性能。

“然而,DETR带来了训练和优化方面的挑战,这需要大规模的训练数据和超长的训练计划。”该团队指出。这样的缺点已经阻碍了DETR性能的进一步改进。研究人员深入研究了DETR结构,确定CNN骨干已被预先训练,以提取良好的视觉表征,但Transformer模块未被预训练。

这是提高性能的关键吗?无监督视觉表征学习在设计良好的代理任务方面取得了显著进展,MoCo和SwAV等模型脱颖而出。但目前的代理任务不能直接应用于训练前的DETR,主要集中在空间定位学习,而不是基于图像实例或聚类的对比学习。

一般来说,无监督学习计算机视觉pipeline包括一个代理任务和一个真正的下游任务,这可能涉及分类或检测不充分的标注数据。Pretext任务需要学习将用于下游任务的视觉表征。

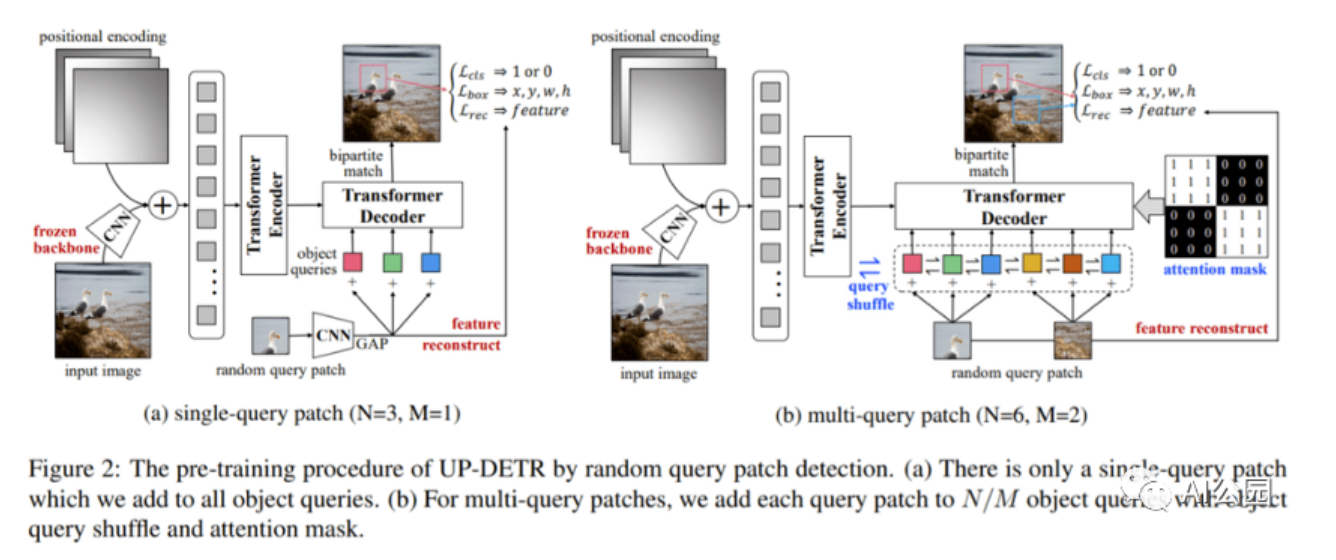

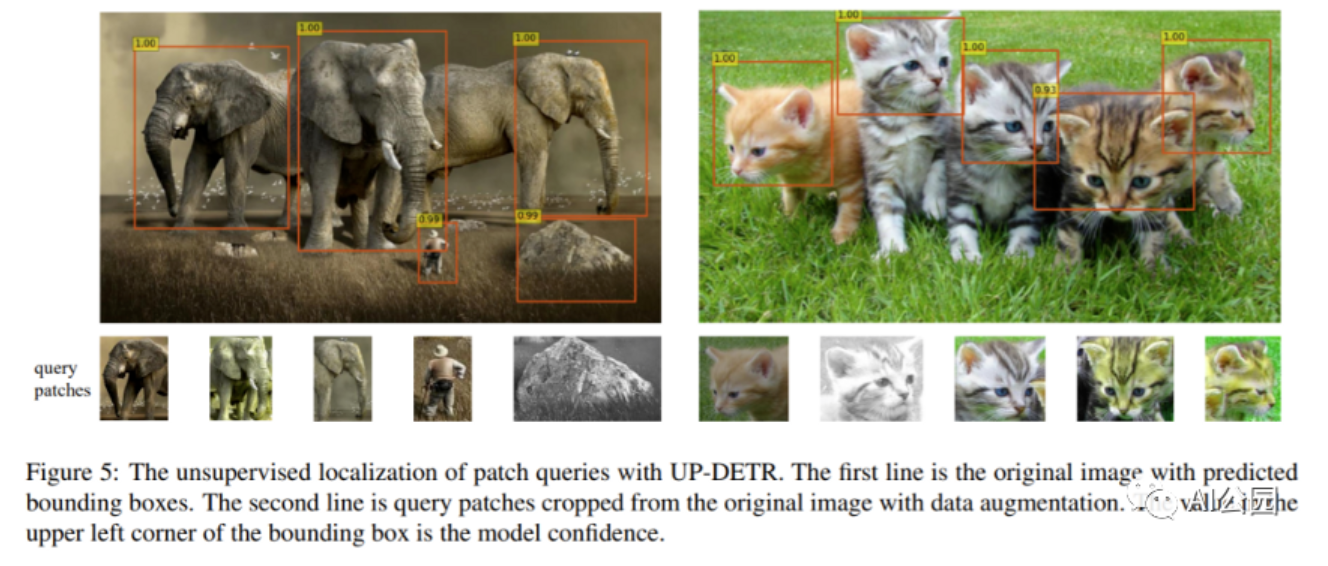

团队着手设计一种新的基于目标检测的DETR架构的预训练Transformer的代理任务,开发了一种random query patch detection method来预训练一个不需要人工标注的DETR检测器。从输入图像中随机裁剪多个query patch后,对Transformer进行预训练,用于检测和预测给定图像中query patch的边界框。这一方法解决了两个关键问题:

- 多任务学习:避免query patch检测破坏分类特征

- 多query定位:不同的目标query关注不同的位置区域和框大小。针对多query patches ,研究人员开发了object query shuffle和attention mask方法来解决query patches 和object query之间的分配问题。

在评估中,UP-DETR以更高的精度和更快的收敛速度大大优于DETR。在具有挑战性的COCO数据集上,UP-DETR在ResNet50骨干下提供了42.8 AP(平均精度),在收敛速度和精度上都优于DETR。

研究人员表示,他们希望未来的研究能够将CNN和Transformer的预训练整合到一个统一的端到端框架中,并将UP-DETR应用于额外的下游任务,如 few-shot目标检测和目标跟踪。

—END—

英文原文:https://medium.com/syncedrevi...

推荐阅读

关注图像处理,自然语言处理,机器学习等人工智能领域,请点击关注AI公园专栏。

欢迎关注微信公众号