ChatGPT可以做什么?可以取代Jack写文章,通过Jack过去文章的学习,AI可以总结出Jack写文章的结构和套路。之后可以输入文章的核心以及相关数据,他可以快速形成Jack的文章;可以取代Jack上班做PPT,特别是汇报总结类的PPT,它都可以快速形成。

这是真的,显然ChatGPT这类通用AI大模型未来可以颠覆很多东西。那么对于ChatGPT这类技术还真应该了解。

所以本文结合相关信息,进行总结

- 什么是ChatGPT,他能够干什么?

- ChatGPT背后的技术是什么?

- ChatGPT当前有什么局限性?

- ChatGPT国内外有哪些同类产品?

- ChatGPT对于汽车技术有什么影响?

帮助自我认知学习,也希望能够给大家带来一些信息和启发。

什么是ChatGPT,他能够干什么?

ChatGPT,首先回归它英语的意思Chat就是聊天,GPT是Generative Pre-trained Transformer的缩写,翻译成生成式预先训练的Transformer,Transformer是完全基于自注意力机制的一个深度学习模型。所以ChatGPT是可以聊天的生成式的、预先训练好的算法模型。它属于当前火热的生成式AI人工智能模型,也就是AI生成人类内容。

ChatGPT对于普通的使用者是一种人工智能聊天机器人,当前主要基于文字聊天,它使用高级自然语言处理(NLP) 与人类进行逼真的对话。目前ChatGPT 可以生成文章、虚构故事、诗歌甚至计算机代码。ChatGPT 还可以回答问题、参与对话,在某些情况下,还可以对非常具体的问题和查询提供详细的答复。

其实聊天机器人可不算什么新鲜玩意,它通过关键词搜索技术,然后匹配回答,这个在我们日常生活中很常见,比如说亚马逊的Alexa,苹果的SIRI,天猫精灵,百度小度等等还有不少在线客服,甚至我们熟悉的汽车语言控制《汽车AI智能语音101及其供应链》,他们主要是基于任务的命令式语音助手。但是ChatGPT确是采用更加精致的大数据训练模型,应用范围更广,可以集成到各种应用中。

ChatGPT 有别于其他聊天机器人和 NLP 系统的一件事是其超现实的对话技巧,包括提出后续问题、承认错误和指出主题细微差别的能力。在许多情况下,基本上如果不是告诉你,人类是很难检测到自己是正在与计算机生成的机器人进行交互。语法和语法错误很少见,书面结构合乎逻辑且清晰。

ChatGPT 的一些功能包括:

- 生成模仿输入数据的样式和结构的类人文本

- 生成对给定提示或输入文本的响应。这可能包括写故事或回答问题。

- 生成多种语言的文本

- 修改生成文本的样式(例如,正式或非正式)

- 提出澄清问题以更好地理解输入数据的意图

- 回复与对话上下文一致的文本,例如提供后续说明或理解对先前问题的引用

其他生成式 AI 模型可以对图像、声音和视频执行类似的任务。

另外ChatGPT可以进行微调训练:通过在较小的相关数据集上进行训练,使 LLM 适应特定任务或领域的过程,这也是ChatGPT目前拓展的商业模式,某个细分领域的应用例如专业的法律顾问,专业的汽车智库专家。

ChatGPT背后的技术是什么?

ChatGPT 是 OpenAI 的最新语言模型NLP(Natural language processing),它是基于大型语言模型LLM(Large Language Model )模型GPT-3 加上使用监督学习和人类反馈强化学习 RLHF(Reinforcement Learning from Human Feedback) 的特殊技术来微调 ChatGPT形成。

其中三个技术关键词

- NLP(Natural language processing)自然语音处理

- LLM(Large Language Model )大型语言模型

- RLHF(Reinforcement Learning from Human Feedback) 人类反馈中的强化学习

NLP自然语言处理,就是人类语言与计算机之间的交互,范围比较大例如之前《汽车AI智能语音101及其供应链》大概分享过。NLP领域流行的技术是深度学习模型,主要依托于以下几项关键技术:魔改的LSTM模型及少量的改进CNN模型,RNN作为典型的特征抽取器;以Sequence to Sequence(或叫encoder-decoder亦可)+Attention作为各种具体任务典型的总体技术框架。

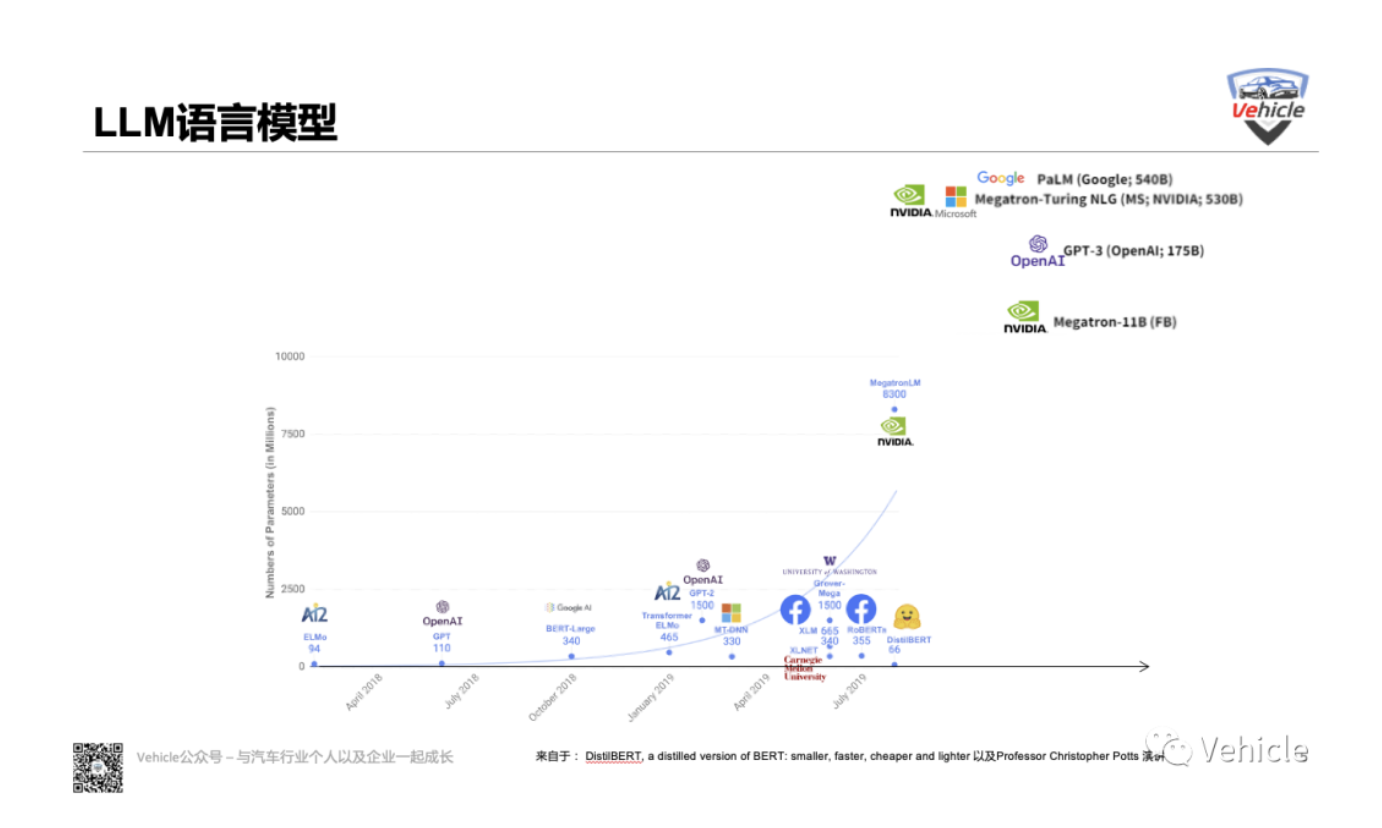

LLM大型语言模型,就是目前ChatGPT所属的模型,是人工智能的一个子集,顾名思义“大“,就是海量数据,它已经在大量文本数据(例如ChatGPT的拓展基础ChatGPT3.0 的数据背后是整个互联网和几百万本书大概3千亿文字)上进行了训练,可以对对话或其他自然语言输入产生类似人类的反应。

它的主要关键技术点是:

- 词嵌入:LLM 中使用的一种算法,以数字形式表示词的含义,以便将其输入 AI 模型并由其处理,通过将单词映射到高维空间中的向量来实现的,其中具有相似含义的单词靠得更近。

- 注意机制:LLM 中使用的一种算法,它使 AI 在生成输出时能够专注于输入文本的特定部分,例如文本中与情感相关的词。这样使LLM 考虑给定输入的上下文或情绪,从而产生更连贯和准确的响应。

- Transformers:LLM 研究中流行的一种神经网络架构,它使用自注意力机制来处理输入数据,从而使它们能够有效地捕获人类语言中的长期依赖关系。

Transformer 经过训练可以分析输入数据的上下文,并相应地对数据的每一部分的重要性进行加权。由于这种类型的模型学习上下文,它通常用于自然语言处理 (NLP)以生成类似于人类书写的文本。

由于它的注意力机制它比之前的RNN《AI 之循环神经网络 RNN 简介 \_ MIT中英字幕版》,GRU 和 LSTM等深度学习算法具有极长的记忆力,Transformer可以“参与”或“关注”之前生成的所有令牌。理论上,注意力机制在提供足够的计算资源的情况下,有一个无限的窗口可供参考,因此能够在生成文本时使用故事的整个上下文。

大型语言模型(例如 GPT-3)根据来自互联网的大量文本数据进行训练,能够生成类似人类的文本,事实上,他们的目标函数是单词序列(或标记序列)的概率分布,使他们能够预测序列中的下一个单词是什么(下面有更多详细信息),所以它们可能并不总是产生与人类期望或理想值一致的输出。

然而,在实际应用中,LLM模型训练的目的是执行某种形式的有价值的认知工作,并且这些模型的训练方式与我们希望使用它们的方式之间存在明显差异。尽管从数学上讲,机器计算出的单词序列的统计分布可能是对语言建模的一种非常有效的选择,但作为人类,我们通过选择最适合给定情况的文本序列来生成语言,并使用我们的背景知识和常识来指导这个流程。当语言模型用于需要高度信任或可靠性的应用程序(例如对话系统或智能个人助理)时,LLM的表现的问题就有:

- 缺少帮助:不遵循用户的明确指示。

- 幻觉:模型编造了不存在的或错误的事实。

- 缺乏可解释性:人类无法理解它是如何做出特定决定或预测的。

- 生成有偏见或有害的输出:在有偏见/有害的数据上训练的语言模型可能会在其输出中重现该结果。

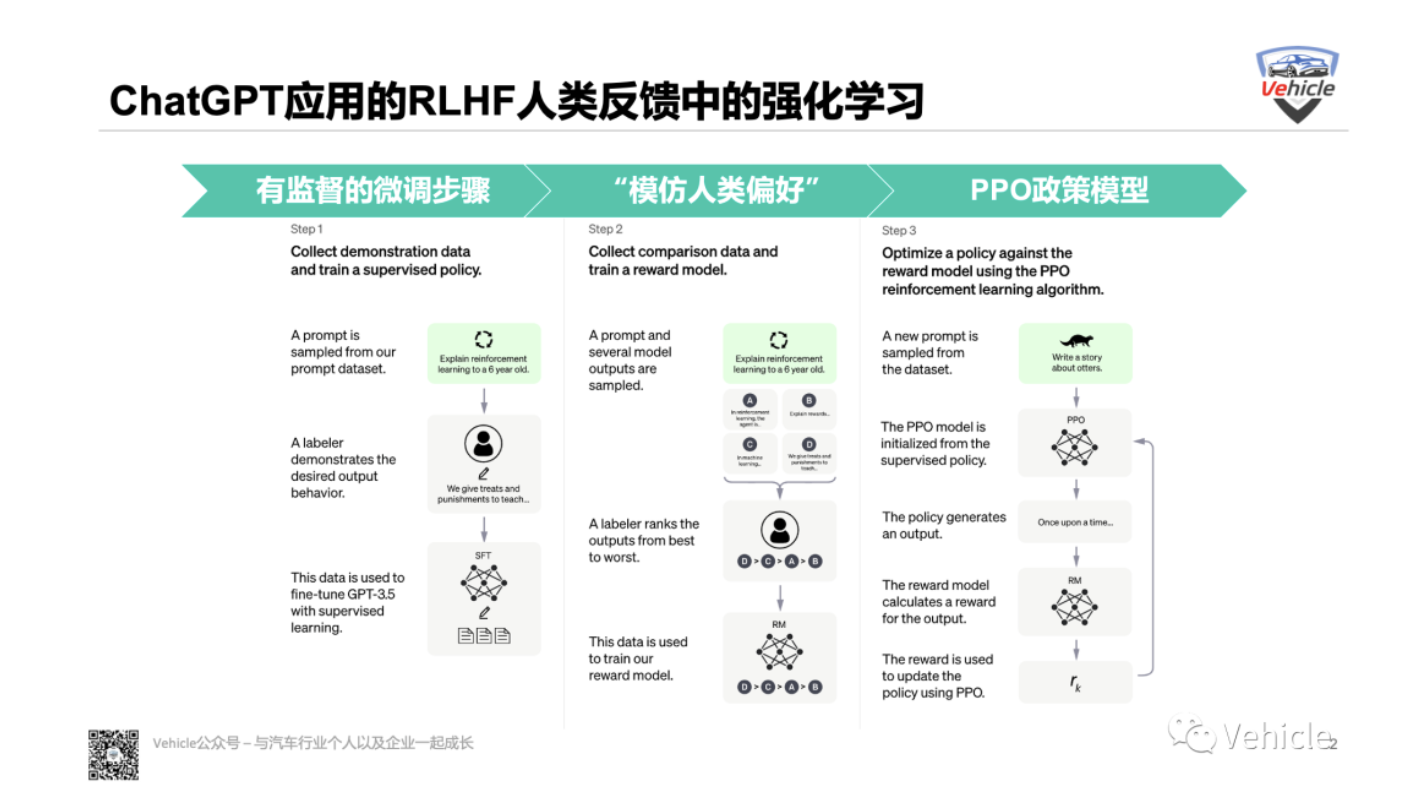

但 ChatGPT 的创建者究竟是如何利用人类反馈来解决对齐问题的呢?这时就需要对LLM进行RLHF(Reinforcement Learning from Human Feedback) 人类反馈中的强化学习。

该方法总体上由三个不同的步骤组成:

- 有监督的微调步骤:首先类似于自动驾驶标记,先人工标记者写下预期的输出响应去训练LLM例如ChatGPT就是微调GPT-3.5 系列。但是显然人工标记成本很高,也听说Open AI资本投资不少在这个方面,所以监督学习步骤的可扩展性成本很高。

- “模仿人类偏好”步骤:这个阶段人工标记者被要求对相对大量的 SFT 模型输出进行投票,这样就创建了一个由比较数据组成的新数据集。在此数据集上训练了一个新模型。这称为奖励模型 (RM)。对于贴标机来说,对输出进行排序比从头开始生产要容易得多,这个过程可以更有效地扩大规模。

- Proximal Policy Optimization (PPO) 步骤:它是奖励模型用于进一步微调和改进 SFT 模型的步骤,这一步的结果就是所谓的政策模型,会根据代理正在采取的行动和收到的奖励不断调整当前策略,而且它将策略的变化限制在与先前策略的一定距离内。

所以在基于人工标注者输入的基础上进行不断强化的训练,本质上他们赋予了ChatGPT的回答。有了RLHF人类反馈中的强化学习,ChatGPT在训练循环中使用人类反馈来最大限度地减少有害、不真实和/或有偏见的输出。

当然有了算法,还需要储存处理数据和运算处理的计算中心,ChatGPT背后的计算中心是微软的Azure云计算中心。

ChatGPT的局限性

那么如此强大的ChatGPT的局限性在熟悉了它背后的核心技术之后可能就明白了,它是基于人类语言文字超大数据积累训练而来,它无法具备思维和创新,主要是基于过去被训练的数据组合而来。

另外对于准确性来讲,当前使语言模型更准确的两个核心相关的功能:

- LLM 从外部来源检索信息的能力。

- LLM 为他们提供的信息提供参考和引用的能力。

所以ChatGPT的答案仅限于已经存储在其训练的信息中,例如我们现在用的ChatGPT就是基于2021年之前的网络数据以及相关书本知识进行学习训练的。在其静态权重中捕获。(这就是为什么它无法讨论 2021 年之后发生的事件,当时模型已经过训练。),如果能够从外部来源获取信息将使 LLM 能够访问最准确和最新的可用信息,即使当该信息经常变化时(例如,公司的股票价格),但显然目前不行。

另外就是人工强化训练的人工标注者赋予的微调,也是当前ChatGPT的局限所在,首先ChatGPT摆脱不了人工标注者的影子例如立场,偏好等。

ChatGPT国内外有哪些同类产品?

那么类似于ChatGPT是不是就一枝独秀?其他人都没有此类产品?其实如上文讲到ChatGPT属于LLM大型语言模型一种,大型语言模型其实在很多互联网公司都有,至于为什么是新势力Open AI先释放引起轰动,其实对于传统势力来讲最怕犯错,所以给了新势力勇敢试错的机会。

其实国外著名的语言模型除了来自 OpenAI的GPT-3 、还有:

- Google的PaLM或LaMDA

- Meta 的Galactica或OPT

- Nvidia/Microsoft 的Megatron-Turing、

- AI21 Labs 的Jurassic-1

当然除了以上国外的Amazon、Microsoft、GitHub、Apple、IBM等也构建了提供不同特性和功能的自然语言处理框架。其中包括数字助理、预测编码工具和聊天机器人,也包含大型语言模型。

国内的Baidu已投入开发类似ChatGPT的相关技术,该项目名字确定为文心一言,英文名ERNIE Bot,3月份完成内测后面向公众开放。目前,文心一言在做上线前的冲刺。

阿里巴巴,根据其内部一名资深技术专家爆料,阿里达摩院正在研发类ChatGPT的对话机器人,目前已开放给公司内员工测试。

另外人工智能聊天软件在国内各大应用平台上并不陌生,如微信官方的小冰,字节跳动旗下的猜猜,腾讯的DOGE,讯飞语音小秘书,图灵机器人等。但这些都不具备如ChatGPT的人工智能效应,大多数并未达到良好的用户体验。但现今有了ChatGPT的成功案例,估计会引发一波国内语言聊天软件和硬件的升级。

但算法的差距,有国内某技术大佬说,中国和国外相差两年以上。

ChatGPT对于汽车技术有什么影响?

那么对于,我们熟悉的汽车行业呢?ChatGPT对于汽车产品和技术有什么影响?先问问万能的ChatGPT。

首先从产品上来讲,改变语音控制,改变汽车语音助手可能是最快和最直接的方式了,大模型下的语言训练,可以通过微调进入汽车领域用于汽车语音识别系统,帮助驾驶员实现语音控制,如语音导航,电话,音乐等。

最典型的有通用的安吉星服务,未来恐怕只需要ChatGPT了。另外座舱语音助手可能兼容座舱控制和聊天服务,变得更加智能和人性化聊天,达到我之前座舱文章《智能座舱系列文一,他到底是什么?》中描述的更加懂人类。

之后从汽车客户服务上来讲,帮助提供快速,准确和个性化的客户服务,从而提高客户满意度。以后的客服电话恐怕都会快速向ChatGPT类似方案靠拢。

所以,从产品应用上来讲,ChatGPT短期内催生汽车语言控制的升级,催生更加智能的语言助手。产品开发流程上来讲可能催生车企内部的知识流程积累。

从产品服务上来讲,ChatGPT短期内会改变售前售后的客服方式,长期可能也改变售后维修诊断方式。

至于对于汽车技术的影响,以语言算法Transformer为基础的ChatGPT获得了极大的轰动,那么无疑给基于视觉算法为基础的智能驾驶一剂强心剂,毕竟当前智能驾驶的图像算法很多是借鉴自更前一步的语言算法。例如Transformer最早被特斯拉应用在其智能驾驶上,目前基本上国内所有智能驾驶的算法都在朝这个方向跑。

总结

最后Meta AI 负责人杨立昆Yann LeCun近日表示:“就底层技术而言,ChatGPT 并没有特别的创新。这不是革命性的,尽管这是公众对它的看法。只是,你知道,它组合得很好,做得很好。”

AI人工智能的底层三大件,数据,算力,算法的发展给ChatGPT的出现提供了爆发的基础,Open AI 将它组合的很好,不但是算法而且还包括了算力,数据。

- 数据方面,互联网的几十年高速发展,积累了海量人类的文本。

- 算力方面,计算机技术的发展,从芯片的制程到类似Chiplet《中国智能汽车芯片的新希望 - Chiplet》,等助力AI芯片蓬勃发展。

- 算法,从神经元算法起步,到Transformer 等各类算法的炉火纯青的应用。

所以AI底层三大件的发展,一定会催生出更多类似于ChatGPT的通用人工智能应用,但我们更应该关注底层三大件的发展,未来数据类似于宝藏和矿产,例如Jack的文章就是私人数据和宝藏,一定可以微调一个数据模型用来套任何课题;芯片算力,成了决胜AI的大器,没有芯片那么数据矿产无法挖掘;算法,犹如矿藏提纯配方。

未来做好AI三大件的工作,才能在AI时代赢得红利。

文章来源:Vehicle

微信公众号:

相关文章推荐

更多汽车行业干货请关注Vehicle专栏欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向