智能驾驶自动驾驶经历过去几年的迅猛发展,技术底层虽然确立人工智能AI赋能发展的根基,但是方法路径却经历了巨大的变化。

例如,当年的感知数据标注量之争,2022年左右的HD高精地图之争,再到2023年的真假无图开城大战,最后到2024端到端智能驾驶大模型上车。

也引发了巨多的智能驾驶热词,数据标注,地图,BEV,Transformer,有无图智驾,大模型上车等等。

回过头来看,我们在讨论这些东西的时候,仅仅看到的是表面,然后基于表面再添加自己认知去解读。

但其实智能驾驶终究只是人工智能AI的应用端,他的发展是跟随人工智能的发展落地,所以看智能驾驶的发展必须紧盯AI的发展。

最近在人工智能领域把控AI三大件中的重要的两大件的英伟达,在其GTC上分享了英伟达对于智能驾驶架构发展的理解,本文将基于其理论整理和分析智能驾驶架构的发展历史以及趋势。

值得智能汽车产业内管理,产品,技术人士,投资,科技爱好者了解和学习,把握智能汽车特别是智能驾驶发展脉络。

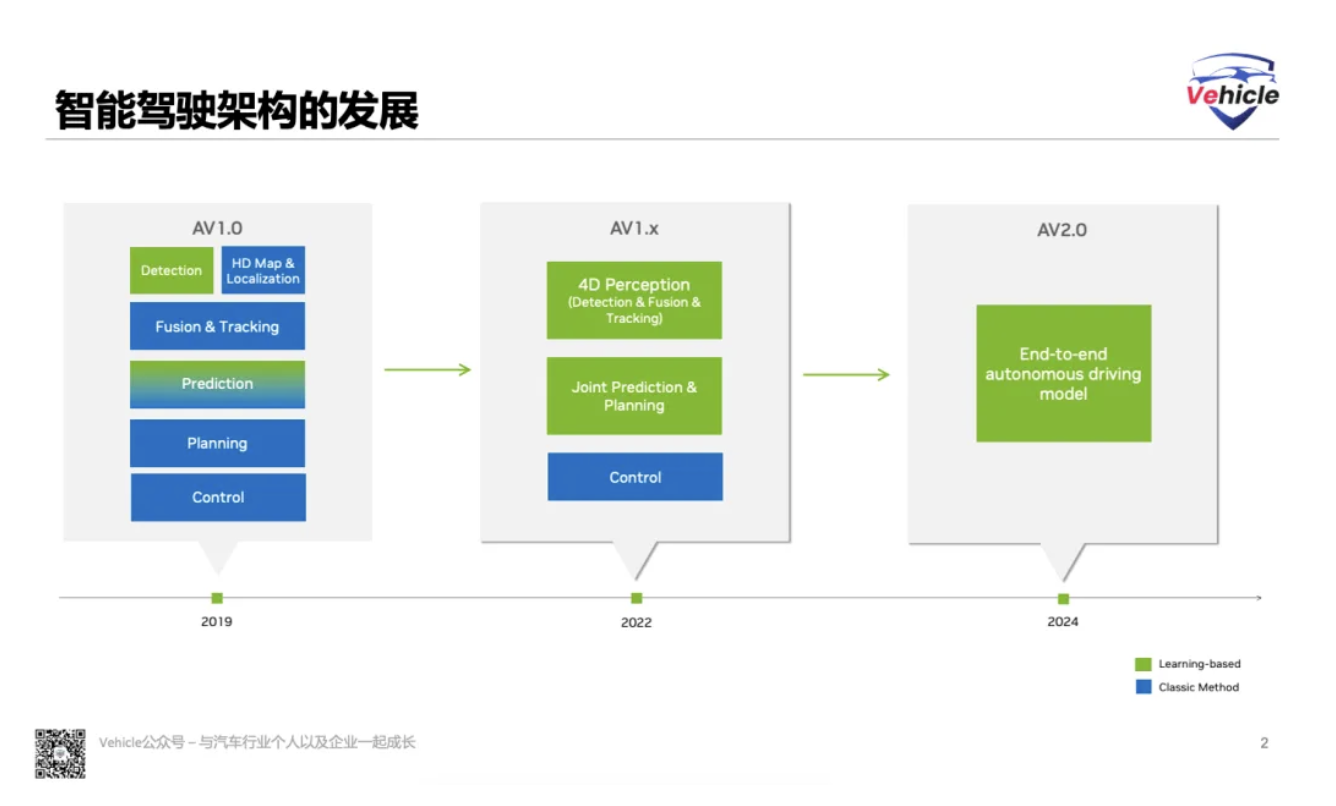

智能驾驶技术架构的发展可以分为四个部分:

- AV1.0 - 目标物识别

- AV1.x - BEV+Transformer+......

- AV2.0 - E2E大模型

- AV2.0 - E2E大模型+LVM图像语言模型

AV1.0 - 目标物识别

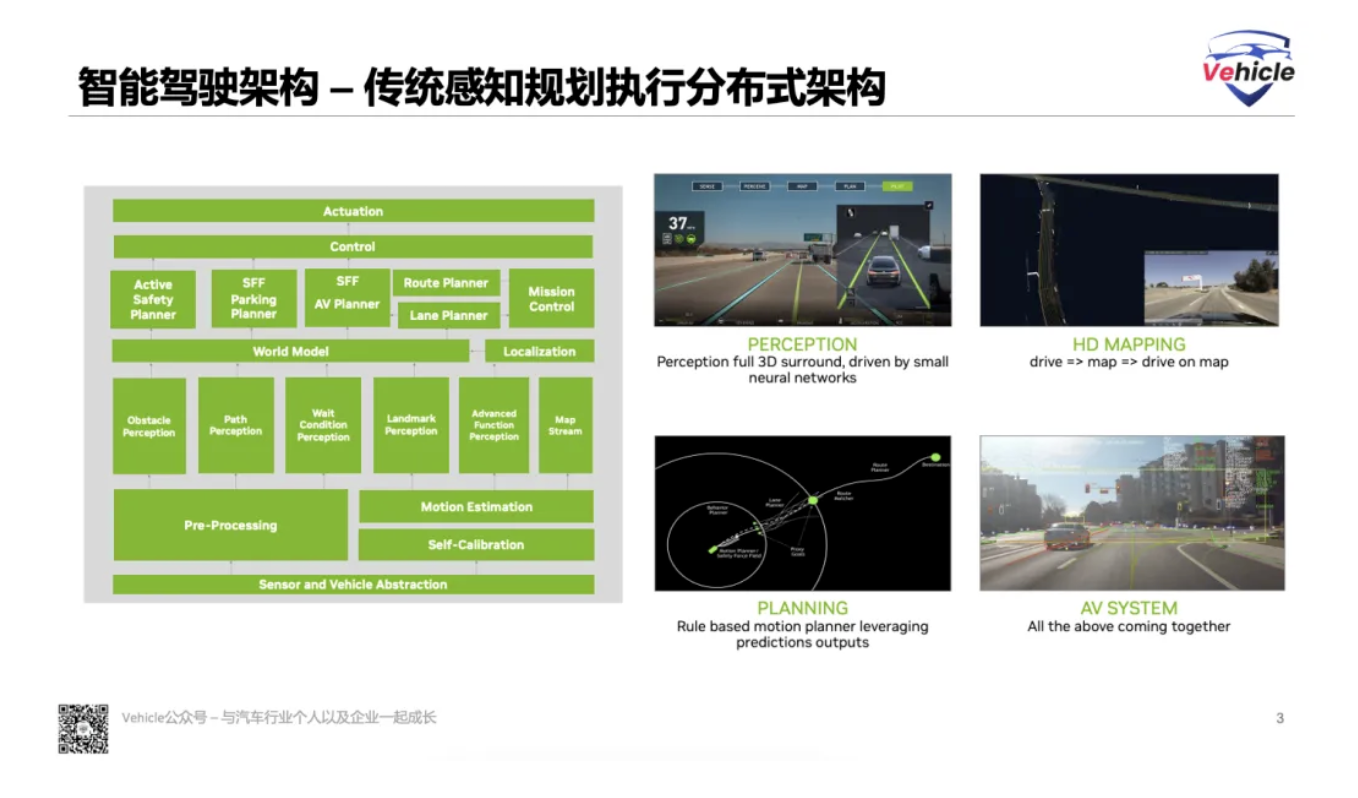

采用经典的智能驾驶步骤,感知,定位,融合跟踪,预测,规划,执行。在智能驾驶开发中也是严格划定每个模块的边界,各司其职。

这时,AI人工智能主要用在目标物识别感知方面,以及少部分预测方面。感知主要是基于视觉的目标物的识别,所以数据标注量决定了感知的精准度;预测采用决策树等算法。规控算法主要采用经典PID。

基本配置主要靠前视觉摄像头感知目标物,所以大家看到的5V(5 vison 5个摄像头,其中4个是环视)方案,大都属于此类。

新势力第一代智能驾驶都采用这类智能驾驶架构,例如,Tesla 特斯拉以及国内新势力 NIO 蔚来,Xpeng 小鹏都是采用Mobileye提供感知的方式实现,在国内新势力以及众多其他推出的第一代高速领航辅助(什么是领航辅助点击浅谈高阶智能驾驶-领航辅助的技术与发展)都是基于此类感知方式配合HD高精地图实现。

但很快随着智能驾驶功能以及覆盖ODD的需求不断扩大,这种分布式模块的智能驾驶架构,由于模块复杂,严重依赖高精地图,所以无法规模化,慢慢被主流抛弃。

AV1.x - BEV+Transformer+......

当国内,在头痛数据标注量,且依然无法破局智能驾驶场景长尾场景时候;在讨论怎么破局HD高精地图的约束等无法规模化的因子时候;马斯克的2021 AI day给行业透露了他技术的关键词:

鸟瞰图(BEV):

BEV主要基于车辆360视觉覆盖的摄像头,提供了一个从上方俯瞰车辆周围环境的视角,它还可以合成多个传感器(如摄像头、雷达、激光雷达等)的数据来生成一个全面的视图。这个视图不仅包括车辆周围的物体,如其他车辆、行人、障碍物等,还包括它们在三维空间中的位置信息。

Transformer模型:

Transformer是一种深度学习架构,最初用于自然语言处理(NLP)领域,因其强大的序列处理和关系建模能力而闻名。在自动驾驶中,Transformer被用来处理BEV数据,以理解和预测不同物体之间的动态关系和交互。

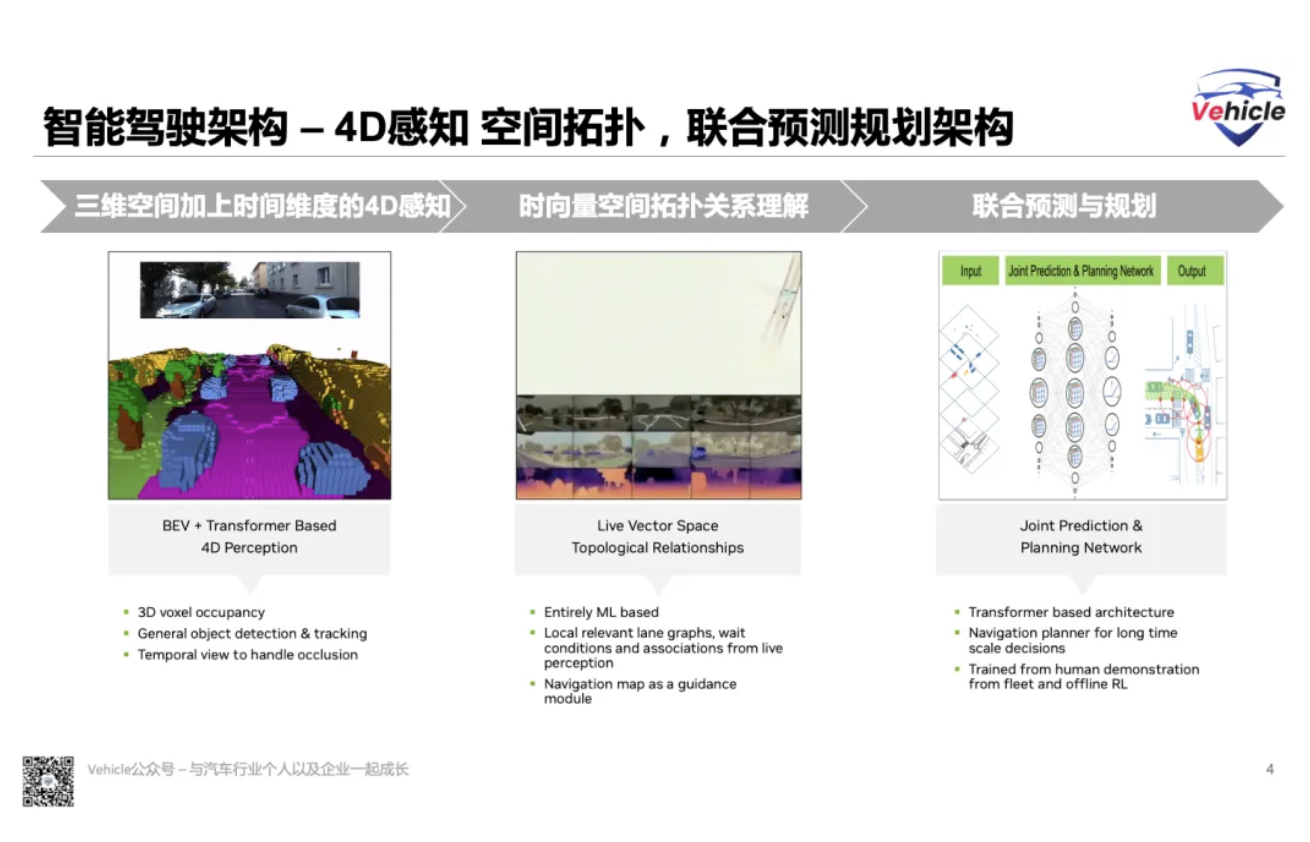

基于这两个关键技术因子,智能驾驶实现了三维空间感知加上时间维度的4D感知。在智能驾驶系统中,这意味着车辆不仅能够实时地检测和跟踪周围的物体(3D感知),还能够预测这些物体在未来一段时间内的状态和行为(时间维度)。

这种4维感知能力对于自动驾驶汽车在复杂和动态的交通环境中进行安全导航至关重要。

2022年特斯拉AI day又带来了

Occupancy占用网格

Occupancy可以直接在BEV空间中完成动态障碍物的3D检测和静态障碍物的识别建模;提供直接在3D空间中感知占用关系,为系统规划提供可行驶空间。

当然占用网格挺吃算力,国内目前有通过激光雷达等其他传感器方式实现,例如之前文章《遥遥领先的华为智驾硬件以及背后的GOD和RCR算法》讲到的GOD。

有了对于环境感知的全面理解,但是交通的另外两个层面: 其他交通参与者的行动轨迹以及道路之间的拓扑关系成了智能驾驶的难点。

这个时候Live Vector Space Topological Relationships"(实时向量空间拓扑关系)登场了

实时向量空间:实时向量空间是指自动驾驶汽车使用传感器数据(如摄像头、雷达、激光雷达等)实时生成的环境表示。这些数据被转换成向量形式,每个向量代表环境中的一个特定对象或特征,例如其他车辆、行人、道路标志或道路边界。

拓扑关系:拓扑关系描述了环境中对象之间的相对位置和相互关系。在自动驾驶的上下文中,这包括了解车辆与其他车辆、行人以及道路基础设施之间的空间关系。例如,一个车辆可能在另一个车辆的前面、后面或侧面,而这些关系对于规划安全行驶路径至关重要。

这样,智能驾驶汽车可以实时处理这些拓扑关系,快速做出决策和反应,实时调整其规划和控制策略以应对动态变化。

通过理解实时向量空间中的拓扑关系,智能驾驶汽车可以更准确地预测其他道路使用者的行为,从而进行有效的导航和决策制定。通过配合SD普通导航信息,可以决策车辆的路线跟随。

例如,如果一个车辆正在靠近并可能在交叉路口处转弯,自动驾驶汽车需要预测这一行为并相应地调整速度和行驶路径。

有了环境的感知以及交通道路的拓扑关系,基本上智能驾驶汽车完成了对World模型的构建,这个时候需要规控出马了。

Joint Prediction & Planning Network(联合预测与规划网络)

传统的自动驾驶系统可能会将感知、预测和规划作为分离的模块来处理。然而,"Joint Prediction & Planning Network" 采用了一种集成的方法,将预测和规划结合在一个统一的框架中。这样做的好处是能够更流畅地处理从感知到行动的转换,并提高系统的整体效率和性能。

联合预测与规划算法是一种基于 Transformer 的架构,通过学习人类驾驶以及强化学习(RL)来实现。

当前国内量产的主流智能驾驶架构都或多或少采用以上方法和技术。

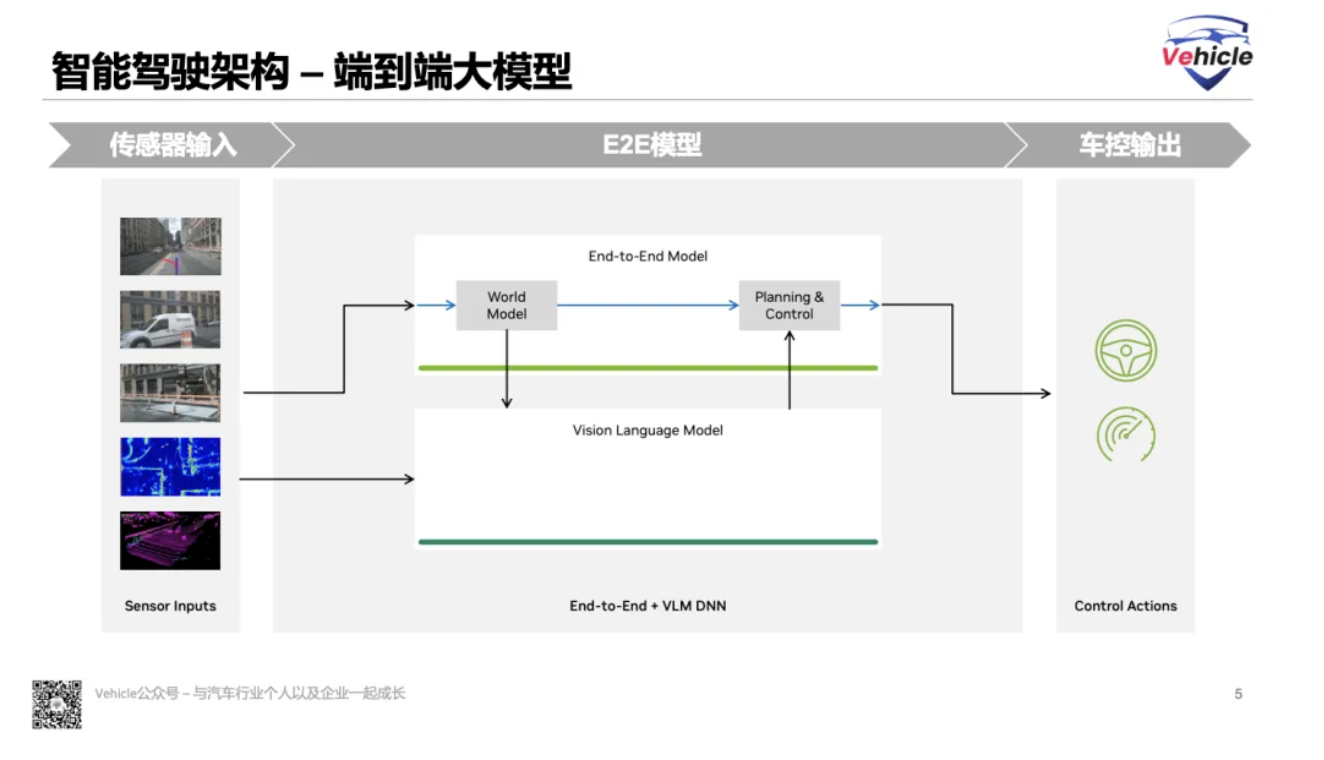

AV2.0 - E2E大模型

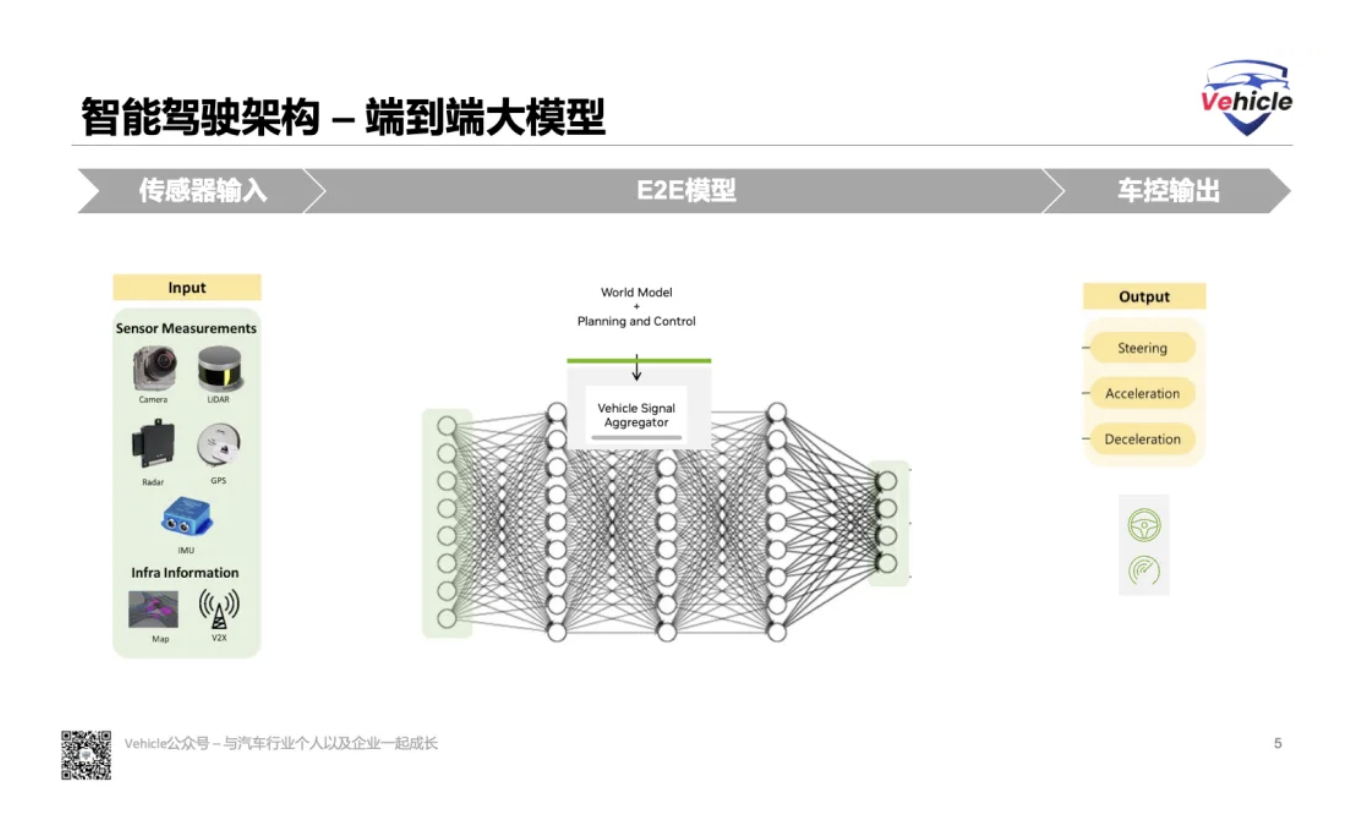

随着生成式人工智能GPT的横空出世,端到端模型也搬上车了。端到端模型,基本就是融合所有的AI model形成一个输入驾驶环境,输出车控的转向,刹车加速等信号。

至于它的内部结构,你可以把它当作一个黑盒,它能够记住你讲过的所有场景,所有case以及你告诉他针对以上场景和case的反馈。在实际自动驾驶中它会基于记忆的场景和反馈去实施。

这个和当前的 ChatGPT 类似,它只能准确回答他知道的东西,不知道的问题,GPT可能会一本正经的说胡话,但如果自动驾驶汽车没见过的场景,自动驾驶随意开,那么就会造成安全事故。

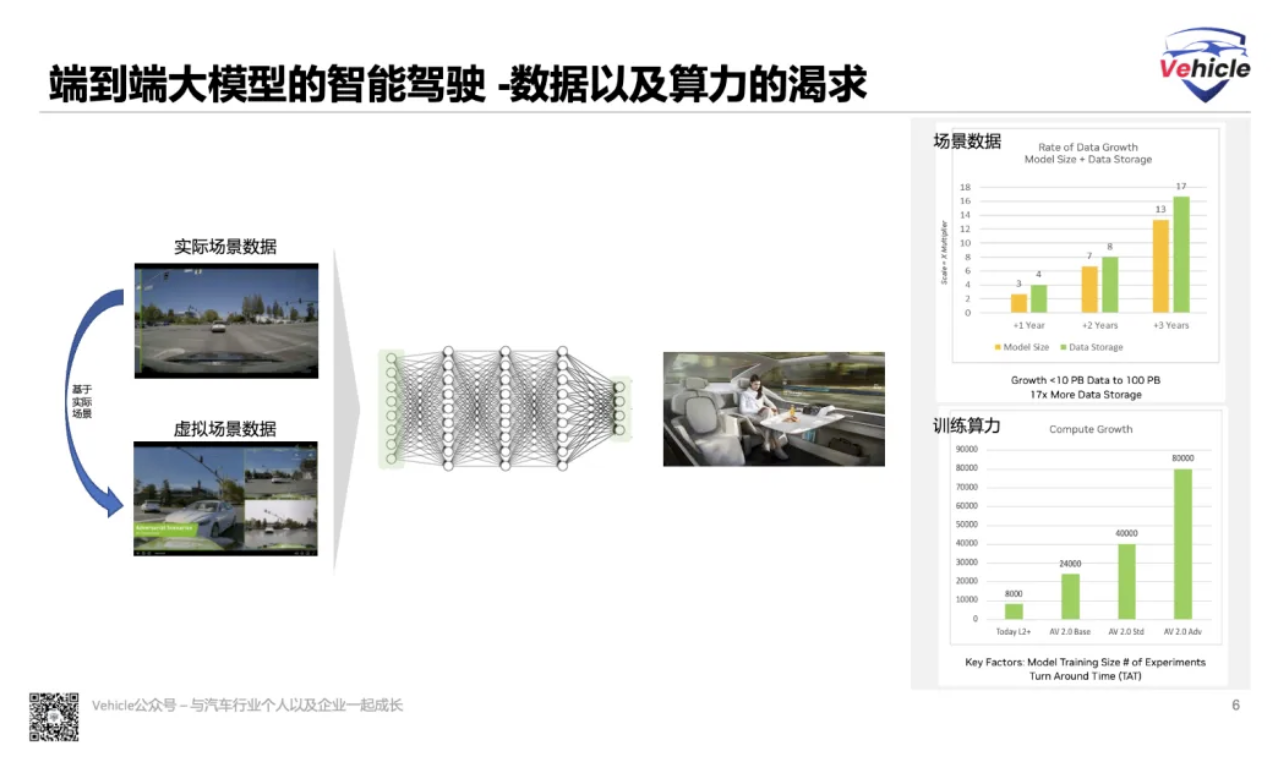

所以问题来了,你必须要去喂这个大模型,足够多的数据,让它学会应对所有场景的驾驶。自动驾驶交通信息数据获取有两种方法:

- 第一种方法是实际道路采集车采集。

- 第二种方法是基于实际场景采集的数据虚拟场景。

自动驾驶端到端算法基于上面的数据进行训练,根据英伟达的 GTC 自驾驶车辆的演讲:

- 智能驾驶大模型的参数的大小,1年之后会增加3倍,2年之后会增加7倍,3年之后增加13倍;

- 智能驾驶大模型训练的数据大小,1年之后会增加4倍,2年之后增加8倍,3年之后增加17倍。

- 算力当前L2+的模型训练需要8000块GPU,如果是基础的智能驾驶大模型的训练算力需要24000块GPU,标准的需要40000块,最多的要高达80000万块。

所以,大模型上车智能驾驶,主要是对于数据以及算力的渴求。数据以及算力为王。

AV2.0 - E2E大模型+VLM视觉语言模型

这或许就是轮回了,轮回到当年基于目标物识别的感知,数据标注量。

如何解决?英伟达抛出行业目前在做的添加 VLM (Vison Language Model) 方法。

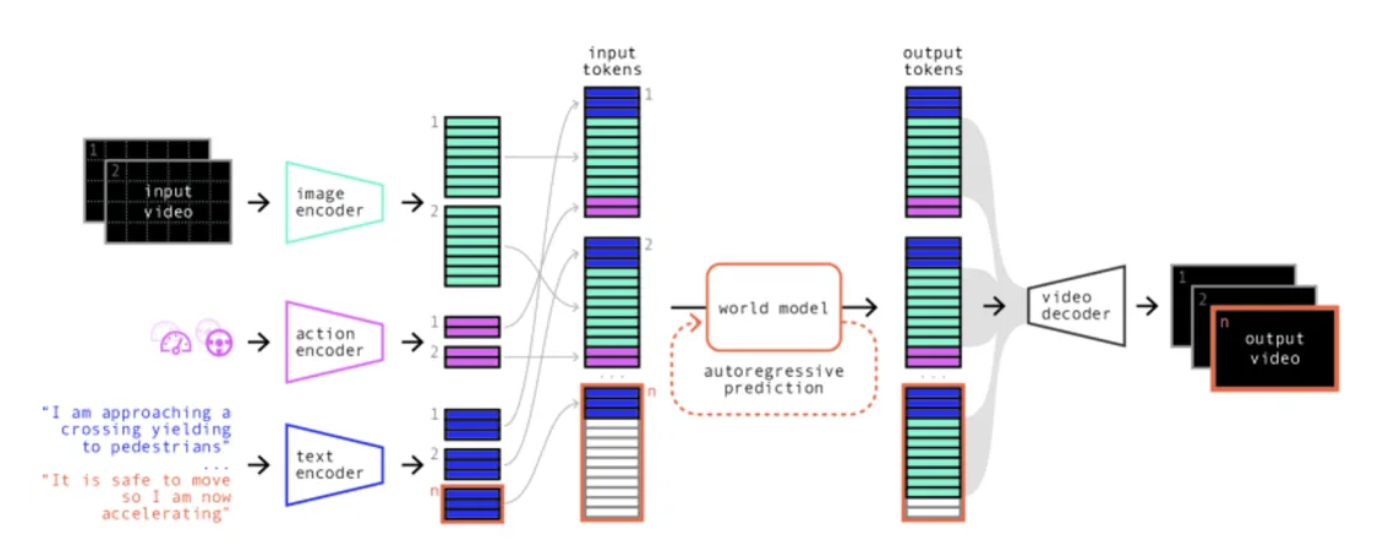

视觉语言模型是一种结合了图像和文本处理能力的机器学习模型,可以理解和解释图像与文本之间的关联,并根据图像生成准确、生动的自然语言描述。

这种模型通过分析图像内容和上下文来生成相关的文字描述,为计算机赋予了更接近人类的视觉理解能力。

例如我们之前文章《探秘美国加州自动驾驶路试:豪横竞逐、勤奋探索与技术挑战》中讲到的Ghost以及英国的Wayve应该都采用类似的技术,识别某个场景时候,通过视觉语言模型解读当前的环境,然后结合语言知识辅助自动驾驶。

打个比方,视觉语言模型识别到当前智能驾驶为学校放学期间,那么自动驾驶自然会明白这个场景需要更加谨慎的驾驶,从而可以更加人性的驾驶。

写在最后 - 端到端大模型智能驾驶的挑战

大模型智能驾驶,也将自动驾驶汽车带回GPT一样的困顿:数据,数据,算力,算力。

但自动驾驶汽车关系到人类的安全,这就更需要大模型实现可靠、安全和高效,基于这些大模型的智能驾驶系统,将面临以下两个主要挑战:

可解释性和透明度:复杂的机器学习和深度学习模型,这些模型往往被认为是“黑箱”操作,因为它们的决策过程难以解释和理解。

在自动驾驶汽车中,这种不透明性可能导致安全问题,因为当发生错误或事故时,难以确定原因并采取纠正措施。此外,可解释性对于建立用户信任、满足监管要求以及在法律纠纷中证明决策过程是合理的也非常关键。

资源和计算效率:深度学习模型和算法通常需要大量的计算资源进行训练和推理。这不仅增加了成本,还可能导致能源消耗和环境影响的增加。

在自动驾驶汽车中,这种资源密集型的计算需求需要通过优化算法和硬件设计来解决,以实现高性能的同时保持能效。此外,随着模型的不断更新和迭代,如何有效地管理和存储这些大型模型和相关数据也是一个挑战。

但不管如何,人工智能高速发展下的智能驾驶正在迅猛发展,发展以及技术能够解决所有问题。

未经准许严禁转载和摘录-参考资料:

- introduce autonomous vehicles - 英伟达

- GAIA-1: A Generative World Model for Autonomous Driving - wayve

作者:Pirate Jack

文章来源:Vehicle

微信公众号:

相关文章推荐

更多汽车行业干货请关注Vehicle专栏欢迎添加极术小姐姐微信(id:aijishu20)加入技术交流群,请备注研究方向