随着大型模型在各行各业的广泛应用,开源大模型生态正在快速发展。研究开源大模型不仅是人类不断接近人工通用智能(AGI)的重要探索之一...

玉米是我国主要粮食作物,种植区域广泛,玉米在不同生长阶段都需要进行病虫害防治。玉米锈病主要侵害叶片,也为害玉米苞叶和叶鞘,严重...

使用煤矿历史事故案例,事故处理报告、安全规程规章制度、技术文档、煤矿从业人员入职考试题库等数据,微调internlm2模型实现针对煤矿事...

作为细胞内无数生化反应的驱动力,蛋白质在细胞微观世界中扮演着建筑师和工程师的角色,不仅催化着生命活动,更是构筑、维系生物体形态...

LLM 大模型学习必知必会系列(十三):基于SWIFT的VLLM推理加速与部署实战1.环境准备GPU设备: A10, 3090, V100, A100均可. {代码...} 2.推...

LLM 大模型学习必知必会系列(八):10分钟微调专属于自己的大模型1.环境安装 {代码...} 2.微调前推理使用python: {代码...} 如果你要进行...

近年来,大规模预训练模型正在引领新一轮人工智能浪潮。「大模型」通过从大规模、多来源的数据中提取深层次规律,进而能够作为「基础模...

本次公开课为极术社区2024年大模型系列第二场公开课,由安谋科技技术专家武大伟Dawei Wu分享。 本期公开课全面解析具身智能的核心概念以...

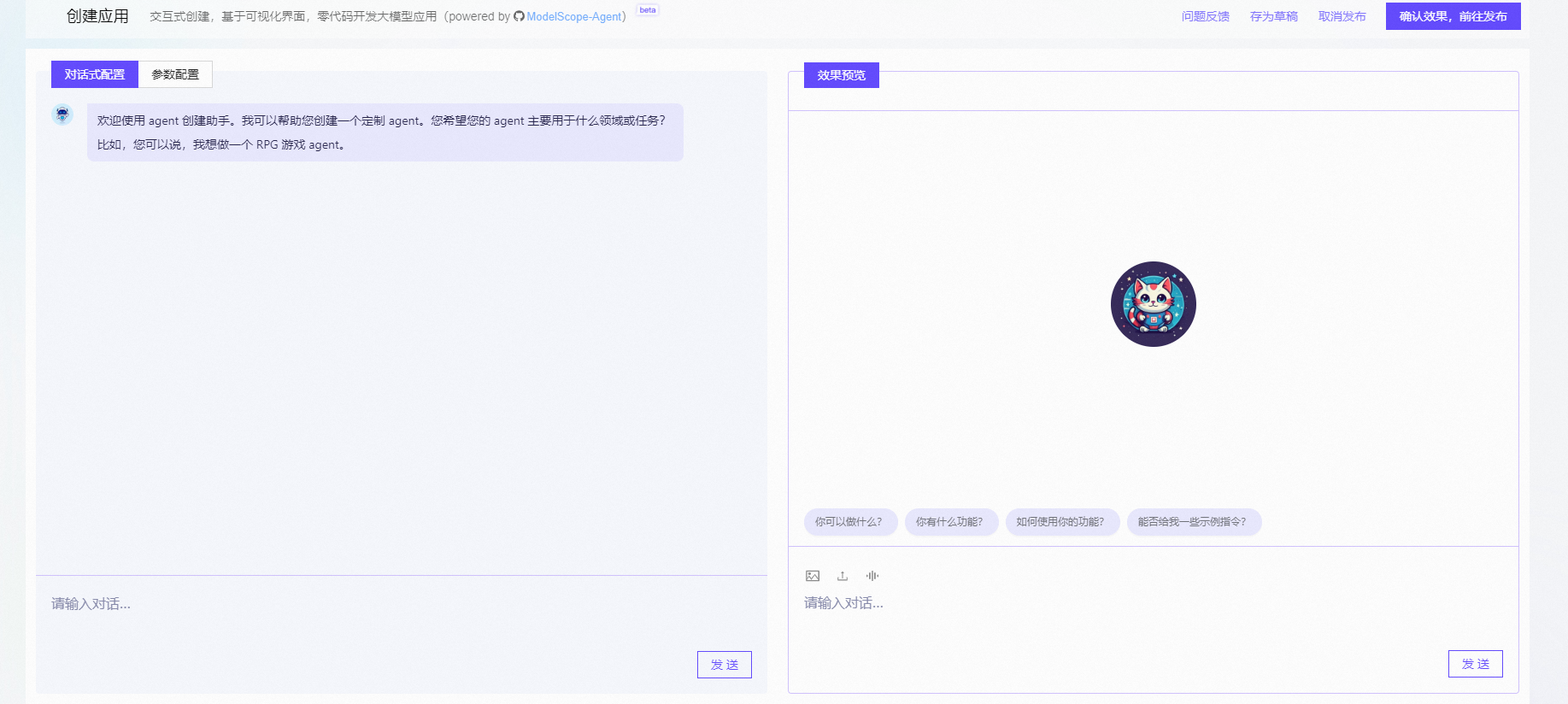

Modelscope 是一个交互式智能体应用基于ModelScope-Agent,用于方便地创建针对各种现实应用量身定制智能体,目前已经在生产级别落地。Ag...

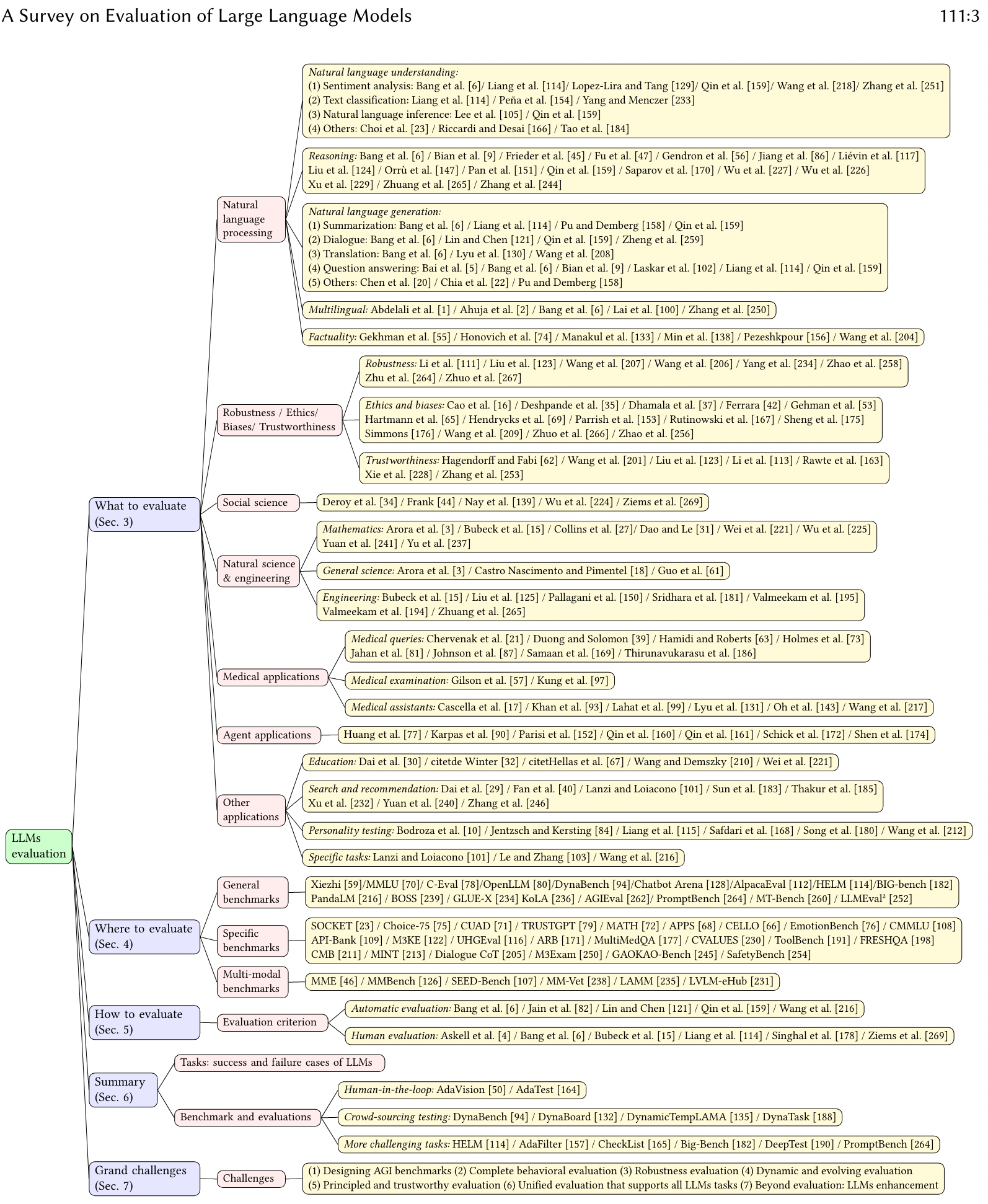

大语言模型(LLM)评测是LLM开发和应用中的关键环节。目前评测方法可以分为人工评测和自动评测,其中,自动评测技术相比人工评测来讲,...

LLM 技术图谱(LLM Tech Map)是将 LLM 相关技术进行系统化和图形化的呈现,此图谱主要特点是“专注于技术人视角”,不求从 LLM 产业角度...

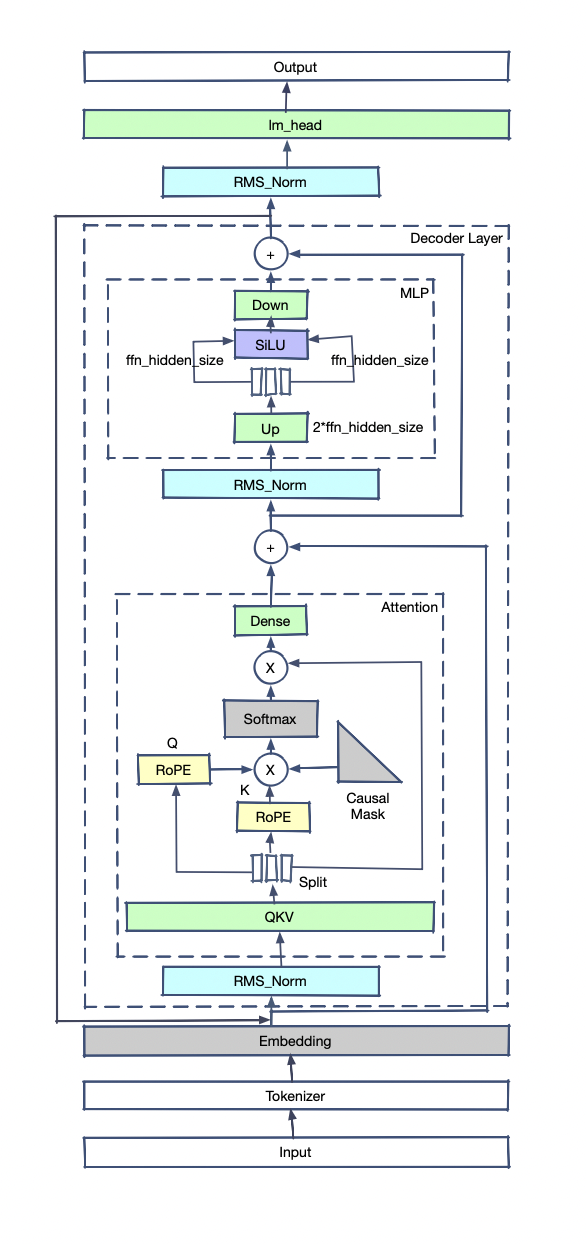

Large Language Model (LLM) 即大规模语言模型,是一种基于深度学习的自然语言处理模型,它能够学习到自然语言的语法和语义,从而可以生...

然而,目前在移动设备上运行的模型相对较小(苹果的是3B,谷歌的是2B),并且消耗大量内存,这在很大程度上限制了其应用场景。

深度学习领域所谓的“模型”,是一个复杂的数学公式构成的计算步骤。为了便于理解,我们以一元一次方程为例子解释:

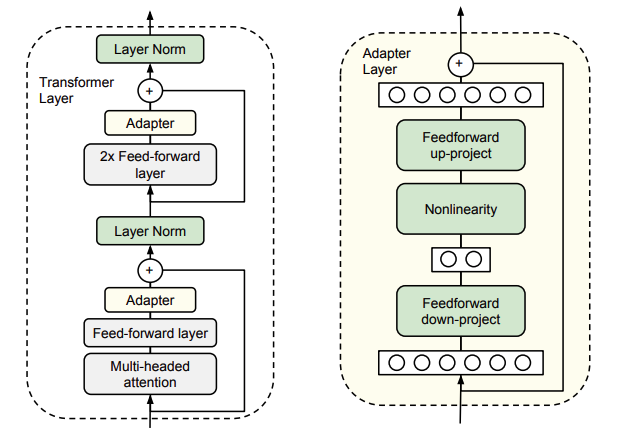

由于LLM参数量都是在亿级以上,少则数十亿,多则数千亿。当我们想在用特定领域的数据微调模型时,如果想要full-tuning所有模型参数,看...

GPU很好,但不是大模型的全部。远比GPU诞生更早的中央处理器芯片——CPU,它在大模型中的地位可能被远远低估了。

过去的一年多,大模型风起云涌,不断迭代,作为一个多年 NLP 产品方向的从业者,可以说是享受其中,惊喜连连。记得22年底,那时疫情放开...

金融,是关乎老百姓钱袋子的国民经济血脉,更是国家核心竞争力的重要组成部分。AI,是当之无愧最具「活力」的行业,也是千行百业革故鼎...

在几个月前nv就发表过关于fp8数制训练和推理的白皮书,大概三四个月前公开了他们针对transformer模型的fp8训练的软件库TransformerEngin...

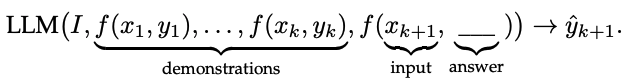

自GPT-3首次提出了In-Context Learning(ICL)的概念而来,ICL目前已经变成了一种经典的LLMs使用方法。ICL,即In-Context Learning,是一...