谷歌的最新的Gemma模型是第一个使用与Gemini模型相同的研究和技术构建的开源LLM。这个系列的模型目前有两种尺寸,2B和7B,并且提供了聊...

1996 年,被誉为爵士乐第一夫人的 Ella Fitzgerald 在位于洛杉矶[比弗利山庄]()的家中去世。这位天才歌手曾获得 13 个格莱美奖、超 4000...

Searchformer是一个基于Transformer架构的人工智能模型,经过训练可以模拟A星寻路算法,在复杂的规划任务中实现更高的效率。它在Sokoban...

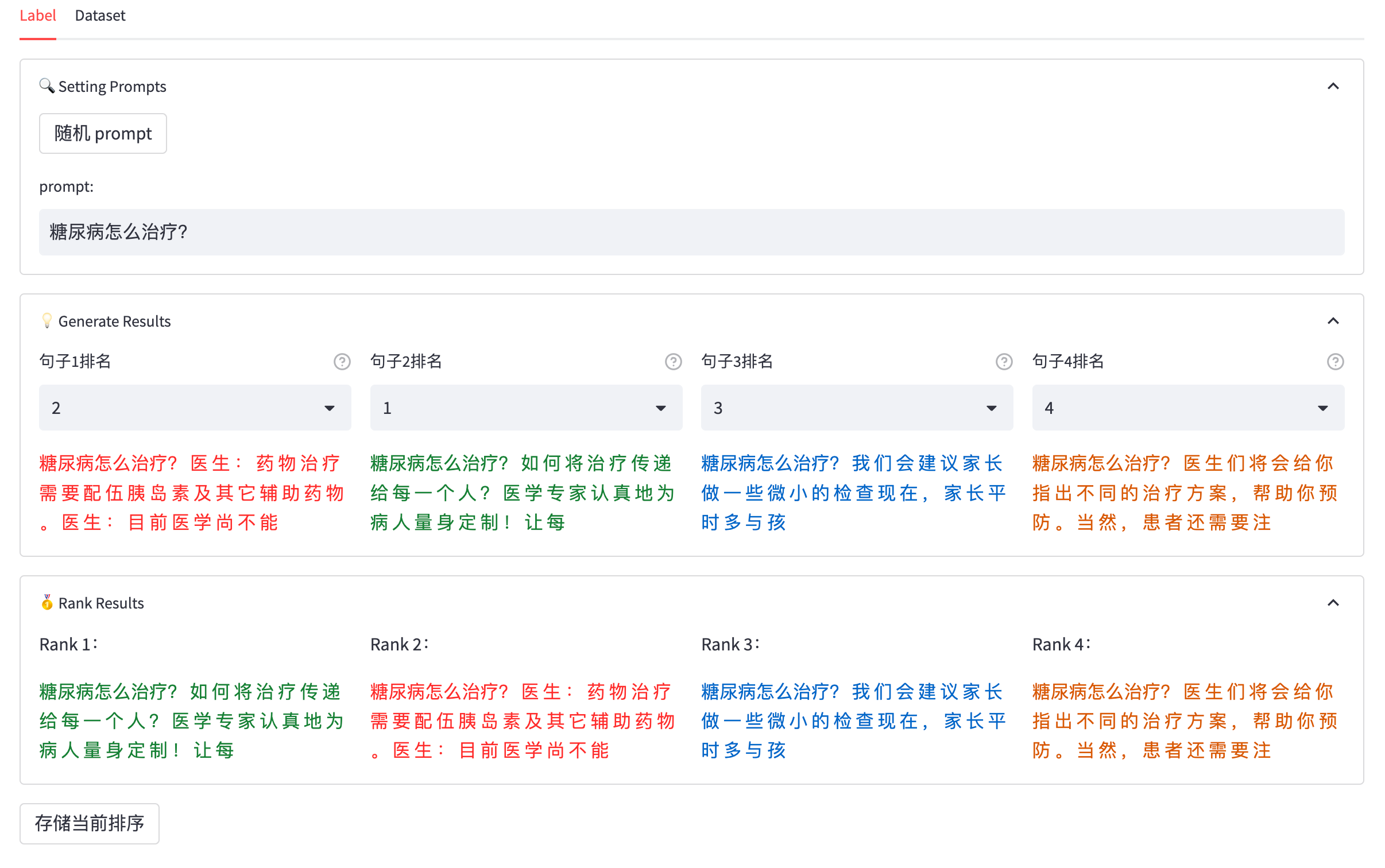

在大模型训练的 RLHF 阶段,需要人工对模型生成的多份数据进行标注排序,然而目前缺乏开源可用的 RLHF 标注平台。

OpenAI最近发布了他们的新一代嵌入模型embedding v3,他们将其描述为性能最好的嵌入模型,具有更高的多语言性能。这些模型分为两类:较小...

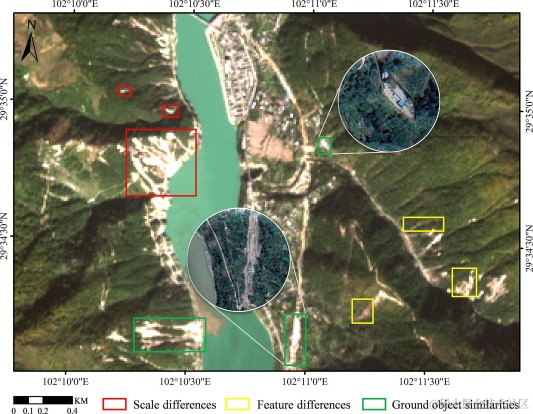

滑坡是最常见的自然灾害之一,通常由地震和降雨引发,会造成严重的财产损失和人员伤亡。由地震触发的山体滑坡所造成的破坏,有时会比地...

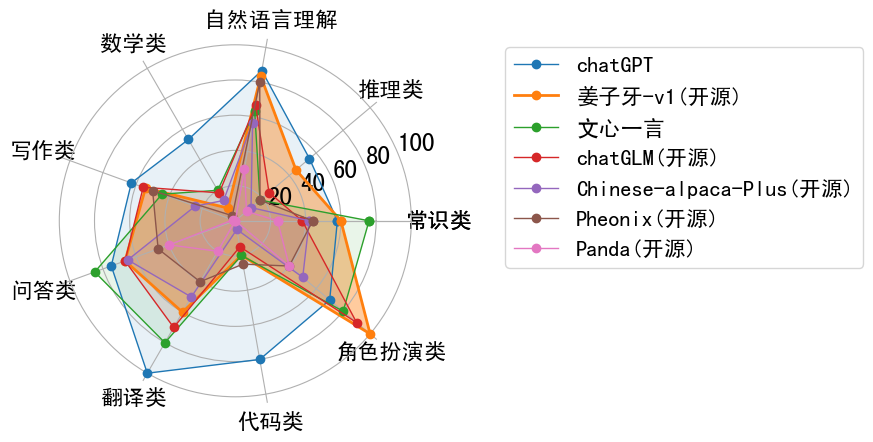

目前大多数开源的ChatLLM项目使用的是其他模型(如:ChatGPT)生成的指令数据,其不可避免的存在数据幻想的问题,数据幻想问题将严重影...

Transformer体系结构已经成为大型语言模型(llm)成功的主要组成部分。为了进一步改进llm,人们正在研发可能优于Transformer体系结构的新...

近日,上海交通大学生成式人工智能研究实验室 (GAIR),开源了专为数学领域量身定制的高质量且多样化的预训练数据集 MathPile,及其可商...

介绍:首先在 Ziya-LLaMA-13B-V1基线模型的基础上加入中医教材、中医各类网站数据等语料库,训练出一个具有中医知识理解力的预训练语言...

LiRank是LinkedIn在2月份刚刚发布的论文,它结合了最先进的建模架构和优化技术,包括残差DCN、密集门控模块和Transformers。它引入了新...

作为人类赖以生存和发展的物质基础,生态环境对人类健康的影响是潜移默化的。近年来,除了力促医疗技术提升、着力完善社保体系等方面外...

2023年是大语言模型和稳定扩散的一年,时间序列领域虽然没有那么大的成就,但是却有缓慢而稳定的进展。Neurips、ICML和AAAI等会议都有tr...

眼睛方寸之间,疾病千差万别。去年底,由爱康集团与鹰瞳 Airdoc 联合发布的《四百万体检人群健康蓝皮书》显示,近年来眼底异常的总检出...

玉兔辞旧岁,金龙启新程。甲辰龙年正月初二,以“龙兴九州 福聚四海”的主题,打造戏曲表达新样态,传递戏曲文化氛围的《2024年春节戏曲晚...

Sora文生视频模型深度剖析:全网独家指南,洞悉98%关键信息,纯干货Sora是一个以视频生成为核心的多能力模型,具备以下能力:文/图生成...

2023年是语言模型(llm)和图像生成技术激增的一年,但是视频生成受到的关注相对较少。今年刚到2月份,OpenAI就发布了一个惊人的视频生成...

国外媒体报道,在2月17日德国慕尼黑的一次安全会议上,包括亚马逊、谷歌、IBM、LinkedIn、McAfee、Meta、Microsoft、OpenAI、Snap、TikT...

稳定扩散模型因其从文本描述生成高质量、多样化图像的能力而获得了极大的关注。但是这些预训练模型在生成高度定制或个性化主题的图像时...

在自然语言生成任务(NLG)中,采样方法是指从生成模型中获取文本输出的一种技术。本文将介绍常用的5中方法并用Pytorch进行实现。